隨著大語言模型的廣泛應用,如何在低成本硬件上實現高性能、高并發的本地化部署成為關鍵需求。vLLM是一個開源的大語言模型推理庫,它能夠顯著提升大語言模型推理的速度和效率,讓開發者可以更高效地部署和運行大語言模型,尤其對于多GPU跑LLM的優化表現突出。在Linux操作系統,Intel在vLLM上提供完整的打包步驟和鏡像,方便用戶進行本地部署大模型,支持多用戶多并發,性能優異。

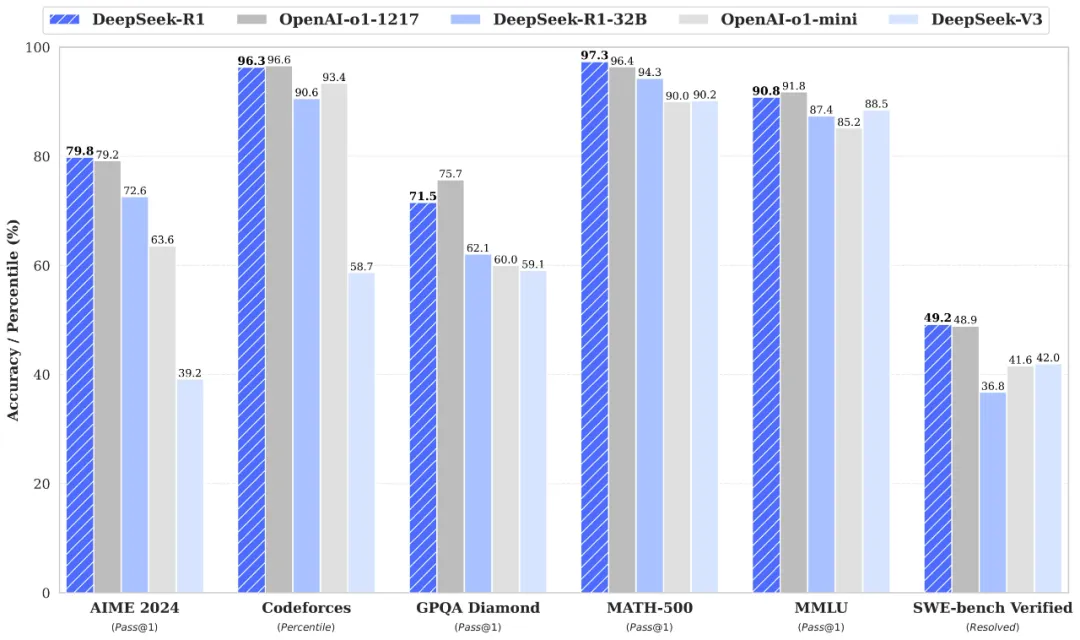

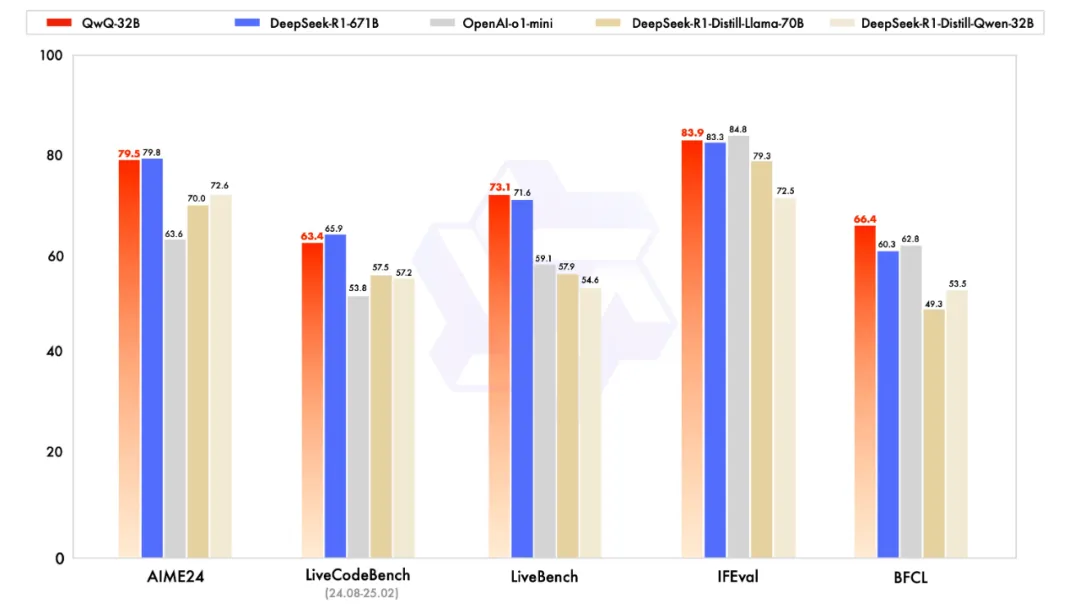

在眾多大模型里,DeepSeek-R1-32B在數學推理、代碼生成與邏輯分析等場景表現尤為突出,實測性能接近 70B 級別模型,成為目前DeepSeek蒸餾模型中的理想優選!

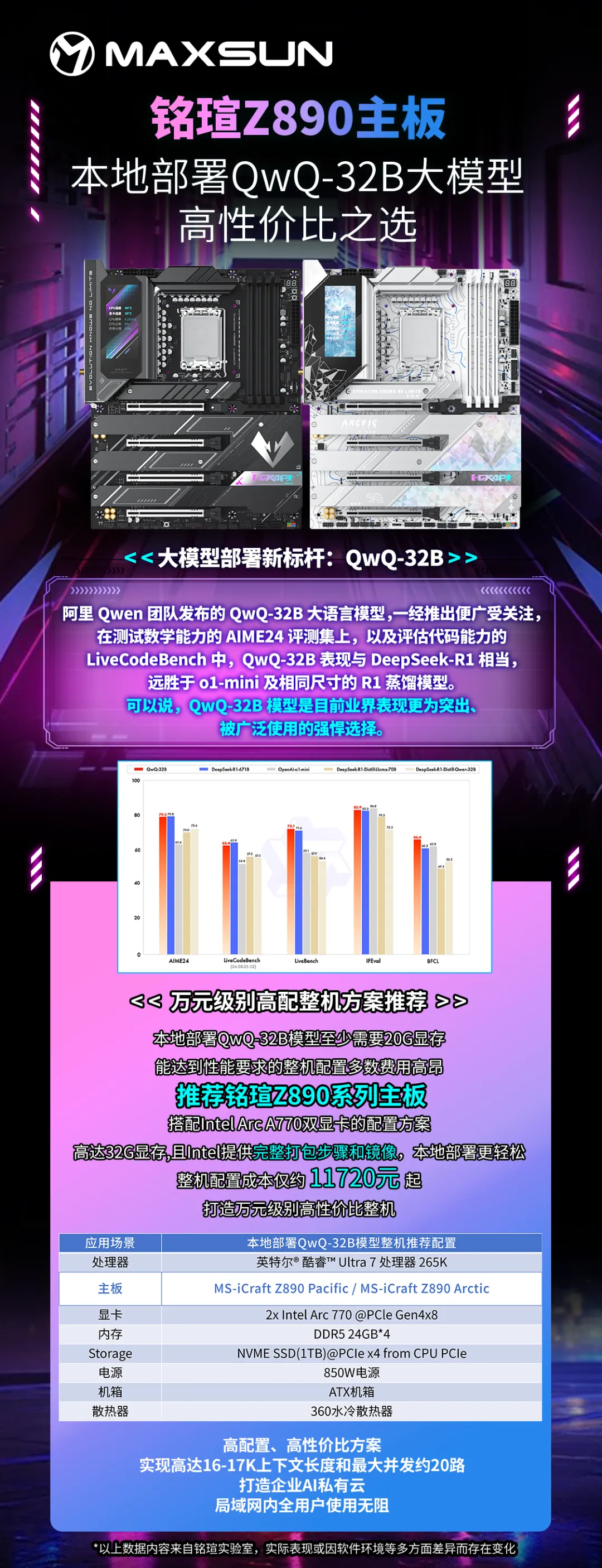

而阿里Qwen團隊發布的QwQ-32B大語言模型,一經推出便廣受關注,在測試數學能力的AIME24評測集上,以及評估代碼能力的LiveCodeBench中,QwQ-32B表現與DeepSeek-R1相當,遠勝于o1-mini及相同尺寸的R1蒸餾模型。可以說,QwQ-32B模型是目前業界表現更為突出、被廣泛運用的強悍選擇。下面就跟大家詳細介紹如何通過Intel在vLLM上提供的完整打包方案和鏡像本地部署DeepSeek 32B和QWQ 32B模型。本地部署32B模型前,需先確認本機具備至少20G顯存以確保充分發揮性能,此次演示使用的配置為:

(以上整機配置成本僅約11720元起,具備更強的性價比優勢)

本地部署DeepSeek 32B模型具體步驟:

1、確認OS版本為:Ubuntu 22.04 + Intel Out-of-Tree GPU drivers.

2、在BIOS設置中,找到“PCI Express Configuration”并且打開“PCIE Resizable BAR Support”

3、進行UBUNTU安裝:

1)安裝Ubuntu22.04.1+Kernel 6.5.0-35-generic

—下載https://old-releases.ubuntu.com/releases/22.04.1/ubuntu-22.04.1 desktop-amd64.iso

—使用燒錄工具 (比如rufus) 來創建U-Disk

—安裝Ubuntu

—確保網絡可以正常使用

2)安裝 Intel Out-of-Tree GPU driver

· # Install the Intel graphics GPG public key

· wget -q0 - https://repositories.intel.com/gpu/intel-graphics.key |

· sudo gpg --yes --dearmor --output /usr/share/keyrings/intel-graphics.gpg

· # Configure the repositories.intel.com package repository

· echo "deb [arch=amd64,i386 signed-by=/usr/share/keyrings/intel graphics.gpg] https://repositories.intel.com/gpu/ubuntu jammy unified" |

· sudo tee /etc/apt/sources.list.d/intel-gpu-jammy.list

· # Update the package repository metadata

· sudo apt update

· sudo apt install -y intel-i915-dkms intel-fw-gpu

3)Configuring Render Group Membership

· sudo gpasswd -a ${USER} render

· sudo reboot

4)驗證Intel® Arc™ A770 PCIe Configuration Space

· #List the VGA device PCIe bus address to confirm 2x A770s are detected

· sudo lspci | grep -i vga

o 03:00.0 VGA compatible controller: Intel Corporation Device 56a0 (rev 08)

o 04:00.0 VGA compatible controller: Intel Corporation Device 56a0 (rev 08)

· sudo lspci -s 03:00.0 -vvv

· #You should see an output as following:

o Capabilities: [420 v1] Physical Resizable BAR

· BAR 2: current size: 16GB, supported: 256MB 512MB 1GB 2GB 4GB 8GB 16GB

5)Install Docker – 或參考https://docs.docker.com/engine/install/ubuntu/

· # Add Docker's official GPG key:

· sudo apt-get update

· sudo apt-get install ca-certificates curl

· sudo install -m 0755 -d /etc/apt/keyrings

· sudo curl -fsSL https://download.docker.com/linux/ubuntu/gpg -o /etc/apt/keyrings/docker.asc

· sudo chmod a+r /etc/apt/keyrings/docker.asc

· # Add the repository to Apt sources:

· echo

· "deb [arch=$(dpkg --print-architecture) signed- by=/etc/apt/keyrings/docker.asc] https://download.docker.com/linux/ubuntu

· $(. /etc/os-release && echo "${UBUNTU_CODENAME:-$VERSION_CODENAME}") stable" |

· sudo tee /etc/apt/sources.list.d/docker.list > /dev/null

· sudo apt-get update

· sudo apt-get install docker-ce docker-ce-cli containerd.io docker-buildx plugin docker-compose-plugin

4、Huggingface 下載 32B-AWQ 模型

1)訪問

https://huggingface.co/Valdemardi/DeepSeek-R1-Distill-Qwen-32B-AWQ

2)下載模型到文件目錄/model(如果沒有該目錄,請在root模式下創建/model)

3)所有鏡像和腳本,已經打包上傳到百度網盤:通過網盤分享的文件:model.zip 鏈接: https://pan.baidu.com/s/1a019IPXap5OmnPM9WICwBg?pwd=mp8w 提取碼: mp8w

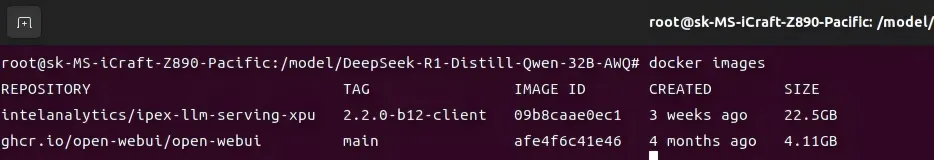

5、載入鏡像

1)載入Intel提供的LLM后端鏡像:

—把ipex-llm-serving.tar.gz 拷貝到本機

—加載docker鏡像:sudo docker load -i ipex-llm-serving.tar.gz

2)載入Intel提供的前端鏡像:

—把openwebui.tar.gz 拷貝到本機

—加載docker鏡像:sudo docker load -i openwebui.tar.gz

3)確認鏡像加載成功:加載成功后sudo docker images 應該出現以下打印:

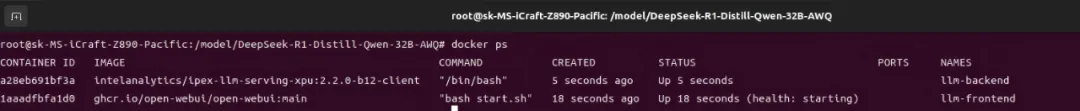

6、啟動容器Pod

1)啟動后端容器:

—把create-llm.sh 拷貝到本機

—啟動腳本:sudo bash create-llm.sh

—如果第一次創建,那么將會有打印,這是正常現象:Error response from daemon: No such container: llm-backend

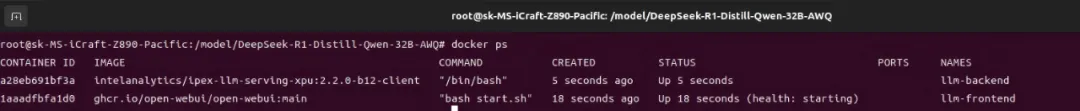

—確認pod已經啟動:

2)啟動前端容器:

—把create-ui.sh 拷貝到本機

—啟動腳本:sudo bash create-ui.sh

—如果第一次創建,那么將會有打印,這是正常現象:Error response from daemon: No such container: llm-frontend

—確認pod已經啟動:

7、啟動應用

1)啟動后端應用:

—新建shell窗口,執行命令docker exec -it llm-backend bash /model/ds.sh

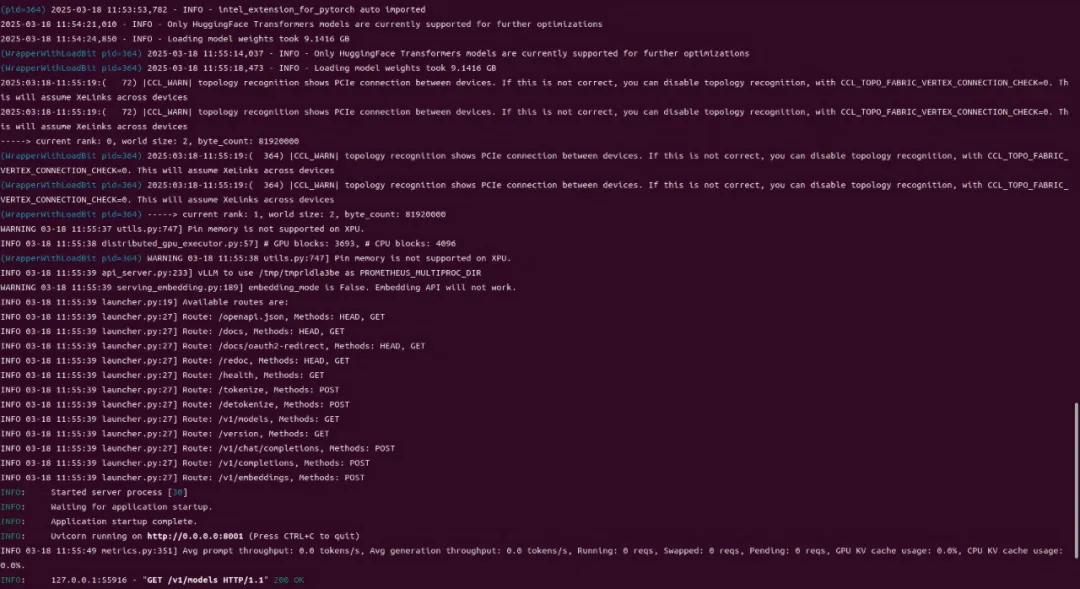

—程序開始后等待約數分鐘,出現如下打印為正常啟動:

2)啟動前端應用:

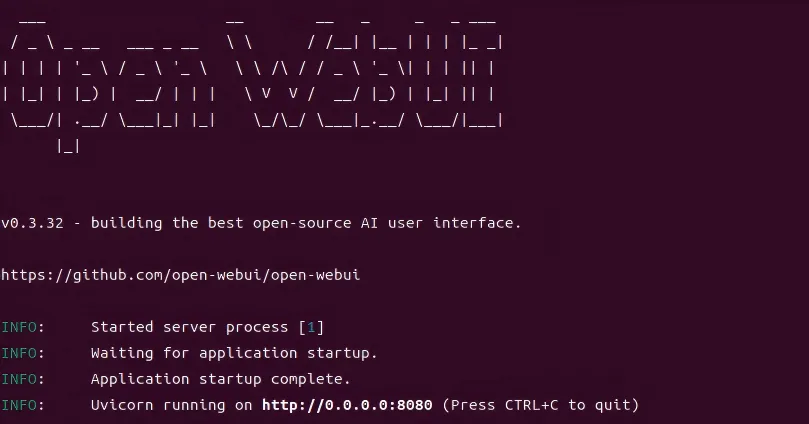

—前端應用為容器自啟動,執行命令docker logs llm-frontend,出現下圖的打印為已經啟動:

3)在啟動完前后端后,需要手動設置顯存頻率和CPU頻率:

— 設置CPU頻率,以Ultra 7 265K為例

cpupower frequency-set -d 3.9GHz

—設置顯存頻率

xpu-smi config -d 0 -t 0 --frequencyrange 2400,2400

xpu-smi config -d 1 -t 0 --frequencyrange 2400,2400

10、交互

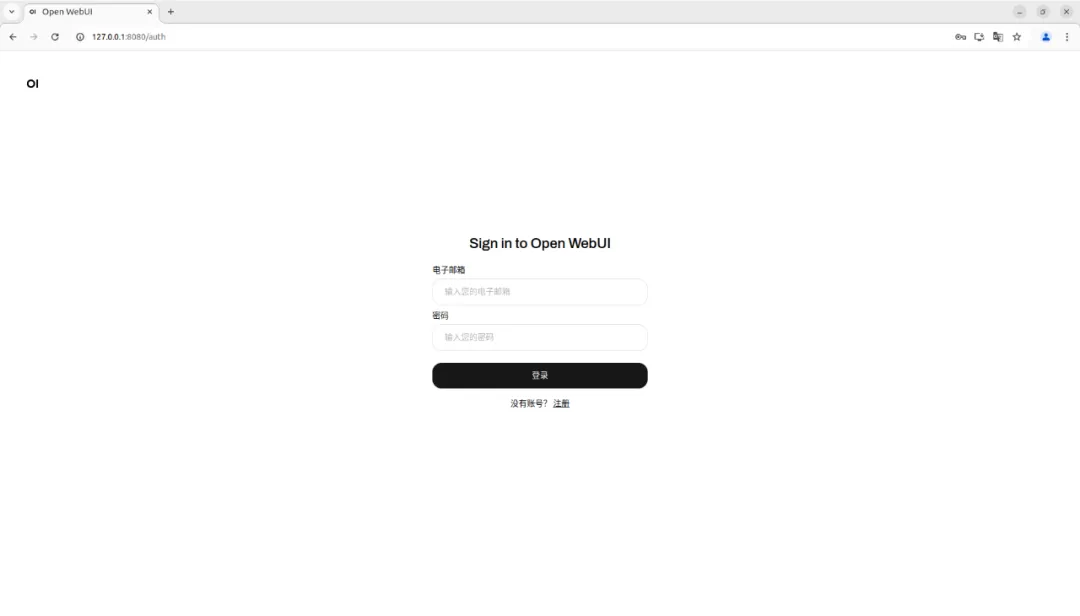

1)圖形界面打開firefox瀏覽器,輸入地址127.0.0.1:8080,跳轉本地前端頁面:

Email填寫admin@intel.com, Password填寫admin完成登錄,如果界面是注冊界面,則按照個人偏好完成管理員注冊即可。

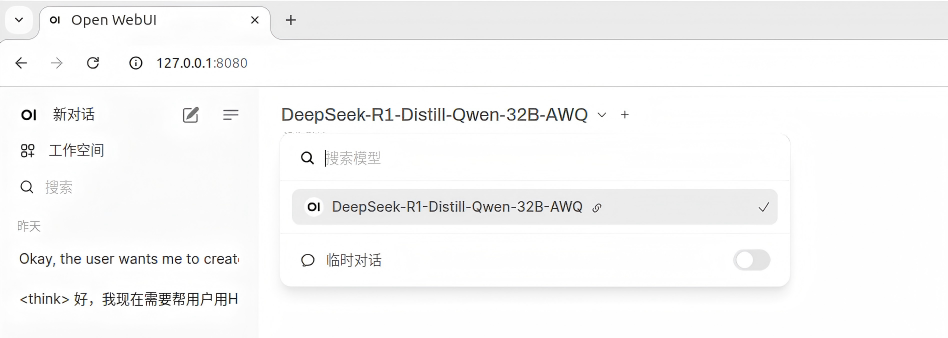

2)如果后端服務正常,在登陸后會在左上角下拉菜單里看到啟動的模型,點擊模型名稱應用該模型:

完成以上操作啟用對應模型,輸入Prompt即可進行推理及內容輸出。

如果需要進行QwQ-32B-AWQ模型的本地部署,只需要基于以上步驟的基礎,進行3步操作:

1)下載QwQ-32B-AWQ模型

https://huggingface.co/Qwen/QwQ-32B-AWQ,下載完成后將模型放在/model下

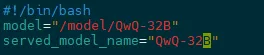

2)修改ds.sh

3)啟動后端,選擇模型名稱應用該模型

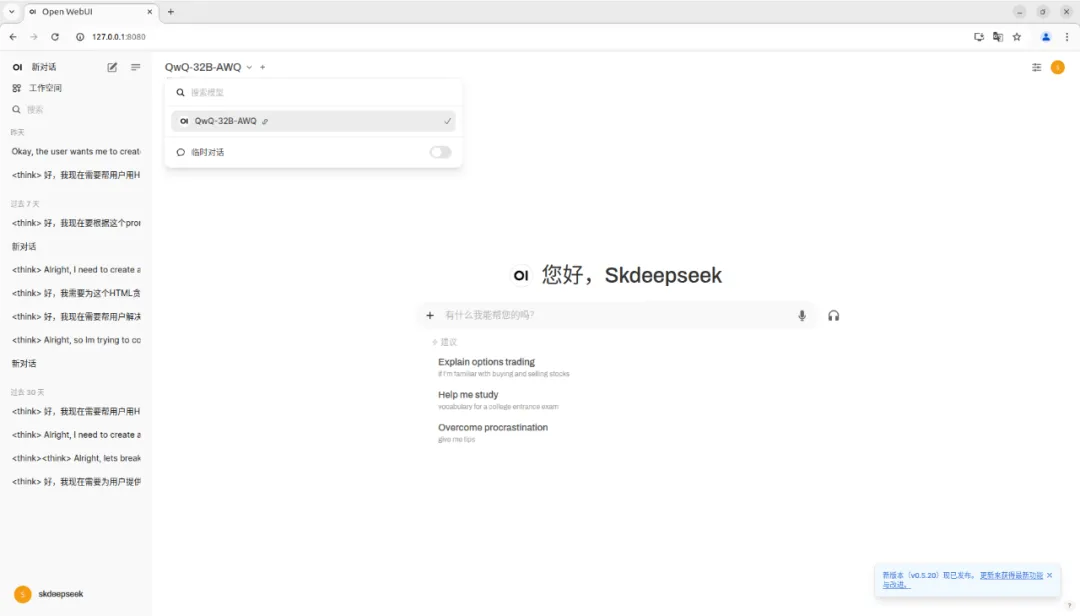

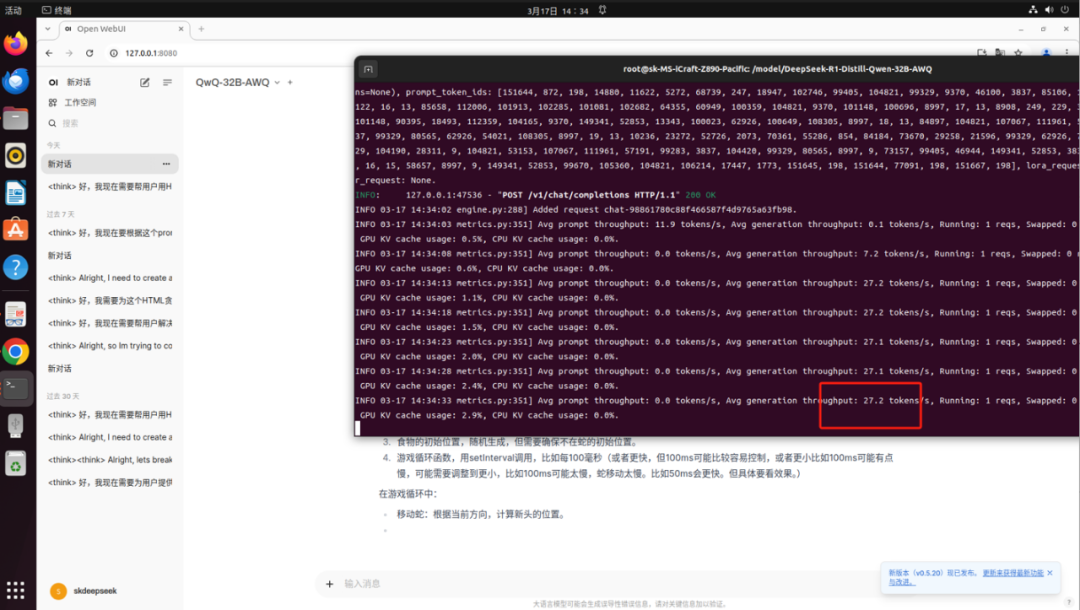

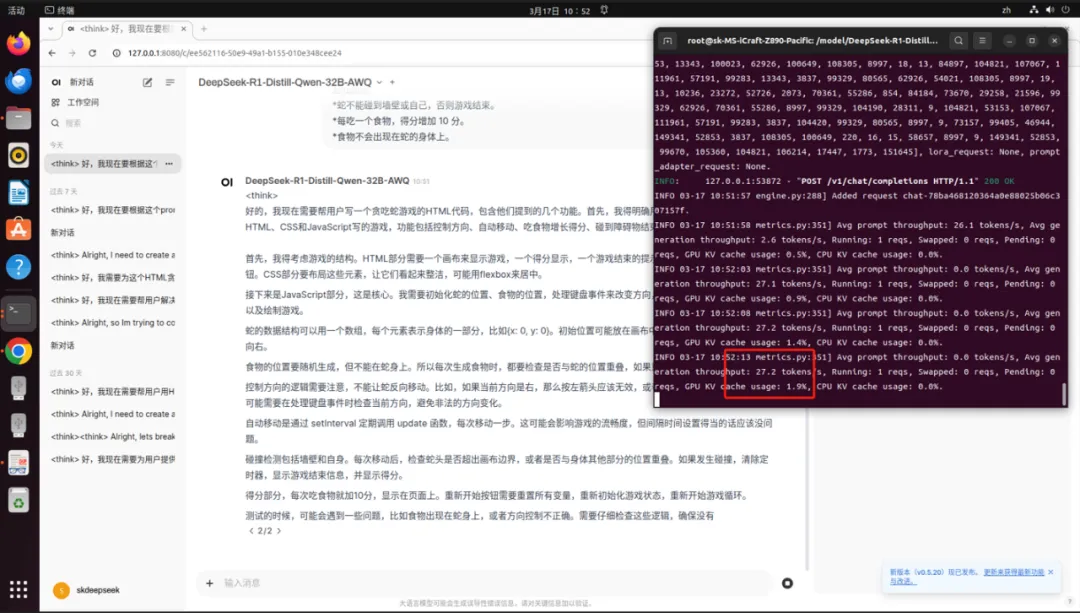

以下為MS-iCraft Z890 Pacific搭載雙Intel Arc A770顯卡運行DeepSeek-R1-Distill-Qwen-32B和QwQ-32B-AWQ的實機截圖,實測輸出Token數為27.2/S,充分滿足日常工作需求。

(QwQ-32B-AWQ運行速度實機截圖)

(DeepSeek-R1-Distill-Qwen-32B運行速度實機截圖)

相較于Windows版本,通過Linux vLLM方案進行大模型的本地部署在多并發優化和多卡優化性能上有明顯優勢。基于vLLM的后端服務框架,能打造一個支持20路并發請求,單路推理速度達10+tokens/s的企業AI私有云,支持局域網內的所有用戶同時訪問。推薦銘瑄Z890主板搭配雙Intel Arc A770顯卡,打造萬元級高配性價比整機方案,實現AI推理、內容輸出高效流暢。

作為iCraft系列下的明星產品,MS-iCraft Z890 Pacific和MS-iCraft Z890 Arctic創新配備一塊3.4英寸銳影LED顯示屏,支持多種模式設置,除了可實時顯示系統信息、個性化開關機畫面外,還可開啟桌面映射,同步顯示專屬畫面或影像。供電方面,采用16+1+1相Dr.MOS直出供電,充分發揮CPU潛能。內存方面,配備4*高速DDR5內存插槽,超頻沖擊8800MHz,同時8層服務器級低損耗PCB和背鉆工藝能有效降低信號損耗、增強信號完整性、助力DDR5高速傳輸。

快來選擇一款銘瑄Z890主板,充分發揮性能潛力,讓 32B 大模型的推理效率與并發能力突破極限吧!